لقد ظلت الخلايا العصبية الاصطناعية – العناصر الأساسية للشبكات العصبية العميقة – دون تغيير كبير لعقود من الزمن. ورغم أن هذه الشبكات العصبية الاصطناعية هي التي تمنح الذكاء الاصطناعي الحديث قوته، إلا أنها غالبًا ما تكون غامضة وغير قابلة للفهم تمامًا 😕.

الخلايا العصبية الاصطناعية المستخدمة في نماذج اللغة الكبيرة مثل GPT-4 تعمل عن طريق استقبال كمية كبيرة من المدخلات، جمعها معًا، وتحويل المجموع إلى مخرجات باستخدام عملية رياضية أخرى داخل الخلية العصبية. هذه الشبكات العصبية المعقدة، والتي تتكون من تجمعات من هذه الخلايا العصبية، يمكن أن تكون صعبة الفهم والتحليل 🤔.

ولكن هناك طريقة جديدة لتجميع الخلايا العصبية تعمل بشكل مختلف قليلاً. يتم تبسيط جزء من التعقيد الموجود في الخلايا العصبية الحالية ونقله إلى خارج الخلايا العصبية نفسها. حيث تقوم الخلايا العصبية الجديدة بجمع مدخلاتها ببساطة وإنتاج مخرجاتها بدون الحاجة إلى العملية المخفية الإضافية. تُعرف الشبكات التي تستخدم هذه الخلايا العصبية الجديدة بشبكات كولموغوروف-أرنولد (KANs)، نسبةً إلى الرياضيين الروس الذين ألهموا هذا المفهوم 🔍.

هذا التبسيط، الذي دُرِس بتفصيل من قبل فريق بقيادة باحثين من معهد ماساتشوستس للتكنولوجيا (MIT)، يمكن أن يجعل من الأسهل فهم سبب إنتاج الشبكات العصبية لبعض المخرجات، ويساعد في التحقق من قراراتها وحتى البحث عن التحيز. الأدلة الأولية تشير أيضًا إلى أنه كلما زادت أحجام KANs، زادت دقتها بشكل أسرع من الشبكات التقليدية المبنية من الخلايا العصبية التقليدية 🚀.

نموذج عمل جديد للشبكات العصبية

يرى أندرو ويلسون، الذي يدرس أسس تعلم الآلة في جامعة نيويورك، أن “هذا العمل مثير للاهتمام. إنه لأمر جميل أن يحاول الناس إعادة التفكير في تصميم هذه الشبكات من الأساس.” 🧠

تم اقتراح العناصر الأساسية لشبكات KAN في التسعينيات، وقد قام الباحثون ببناء نسخ بسيطة من هذه الشبكات. ولكن فريق MIT قام بتطوير الفكرة بشكل أكبر، حيث قاموا ببناء شبكات KAN أكبر وأجروا اختبارات تجريبية عليها، كما قاموا بتحليل بعضها لتوضيح كيف يمكن للبشر تفسير قدرتها على حل المشكلات 🔧.

يقول زيمينغ ليو، طالب دكتوراه في مختبر ماكس تيغمارك في MIT: “لقد قمنا بإحياء هذه الفكرة، ونأمل أنه مع التفسيرية، قد لا نضطر بعد الآن إلى اعتبار الشبكات العصبية صناديق سوداء” 🌈.

رغم أن الأبحاث لا تزال في مراحلها الأولى، إلا أن العمل على KANs جذب الكثير من الانتباه. ظهرت صفحات على GitHub توضح كيفية استخدام KANs لتطبيقات متنوعة، مثل التعرف على الصور وحل مشاكل ديناميكا السوائل 🌊.

البحث عن الصيغة المثلى

جاء التقدم الحالي عندما كان ليو وزملاؤه في MIT وكالتك والمعاهد الأخرى يحاولون فهم الأعمال الداخلية للشبكات العصبية الاصطناعية التقليدية 💡.

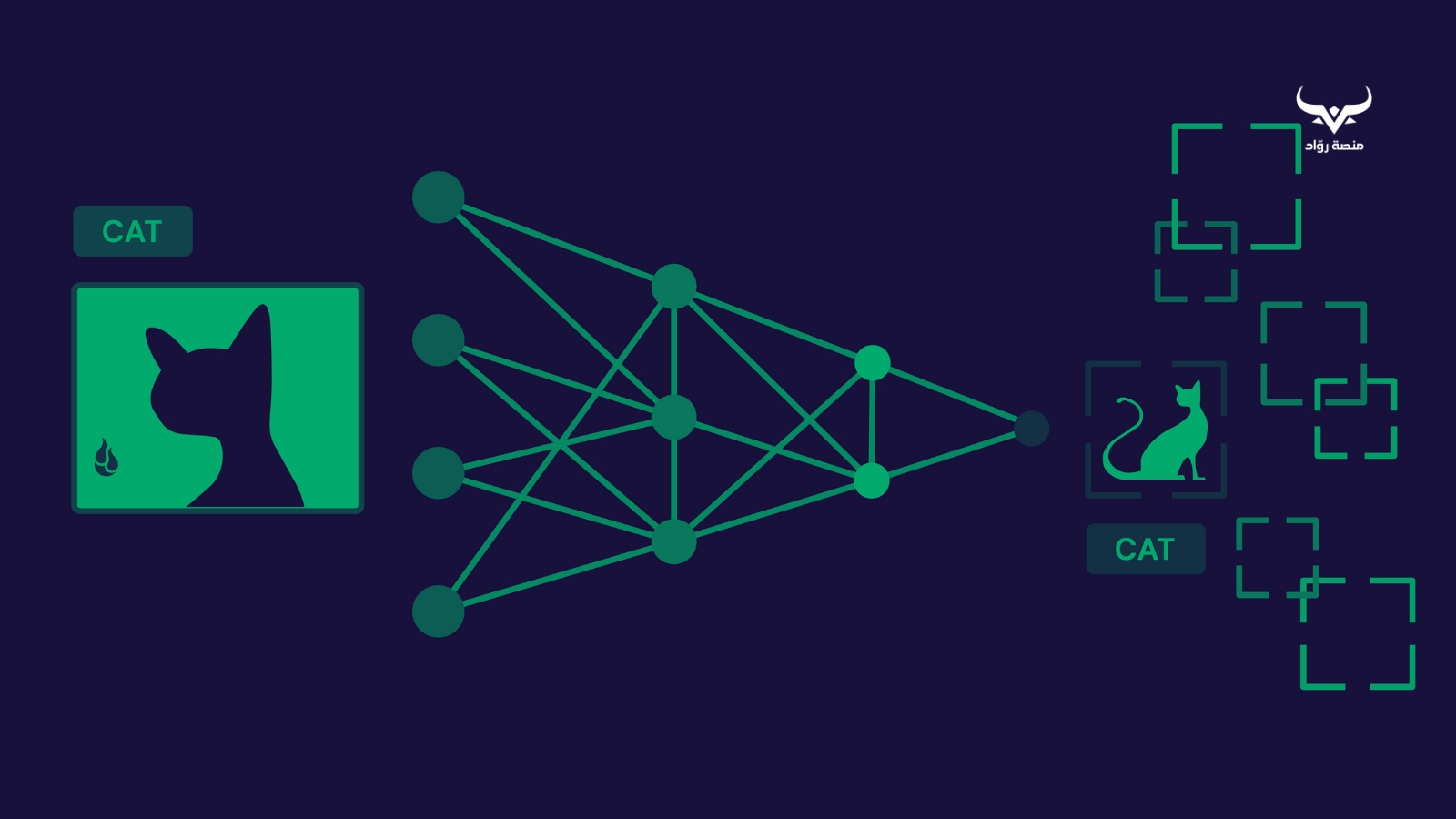

اليوم، تتضمن جميع أنواع الذكاء الاصطناعي تقريبًا، بما في ذلك تلك المستخدمة في بناء نماذج اللغة الكبيرة وأنظمة التعرف على الصور، شبكات فرعية تُعرف بالشبكة العصبية متعددة الطبقات (MLP). في MLP، يتم ترتيب الخلايا العصبية الاصطناعية في “طبقات” مترابطة بكثافة. تحتوي كل خلية عصبية على “دالة تفعيل”، وهي عملية رياضية تأخذ مجموعة من المدخلات وتحولها بطريقة محددة مسبقًا إلى مخرجات 📊.

في MLP، تستقبل كل خلية عصبية مدخلات من جميع الخلايا العصبية في الطبقة السابقة وتضرب كل مدخل بوزن معين (وهو رقم يرمز إلى أهمية هذا المدخل). ثم يتم جمع هذه المدخلات المضروبة وتغذيتها إلى دالة التفعيل داخل الخلية العصبية لتوليد مخرجات، والتي يتم تمريرها بعد ذلك إلى الخلايا العصبية في الطبقة التالية 🔄. تتعلم MLP التمييز بين الصور، مثل صور القطط والكلاب، عن طريق اختيار القيم الصحيحة لأوزان المدخلات لجميع الخلايا العصبية 🐱🐶.

بمجرد تدريب الشبكة، تعمل جميع خلايا MLP وروابطها مجتمعة كدالة أخرى تأخذ مدخلًا (مثل عشرات الآلاف من البكسلات في صورة) وتنتج المخرجات المرغوبة (مثل 0 للقط و1 للكلب). فهم الشكل الرياضي لهذه الدالة أمر مهم لفهم سبب إنتاجها لبعض المخرجات. على سبيل المثال، لماذا تصنف شخصًا على أنه مؤهل للحصول على قرض بناءً على مدخلات حول وضعه المالي؟ ولكن MLPs هي صناديق سوداء، ومن المستحيل تقريبًا تحليل الشبكة بشكل عكسي لمهام معقدة مثل التعرف على الصور 🔍.

حتى عندما حاول ليو وزملاؤه تحليل MLP لمهام أبسط تتضمن بيانات “اصطناعية” مخصصة، واجهوا صعوبة كبيرة. يقول ليو: “إذا لم نتمكن من تفسير هذه البيانات الاصطناعية من الشبكات العصبية، فسيكون من المستحيل التعامل مع مجموعات البيانات الواقعية” 😅.

إعادة تشكيل الرياضيات

كان التغيير الرئيسي هو إزالة دالة التفعيل الثابتة وإدخال دالة بسيطة قابلة للتعلم لتحويل كل مدخل قبل دخوله إلى الخلية العصبية 🎯.

بعكس دالة التفعيل في خلية MLP، التي تأخذ في الحسبان العديد من المدخلات، تأخذ كل دالة بسيطة خارج خلية KAN عددًا واحدًا وتنتج رقمًا آخر. الآن، خلال التدريب، بدلًا من تعلم الأوزان الفردية، كما يحدث في MLP، تتعلم KAN كيفية تمثيل كل دالة بسيطة. في ورقة بحثية نُشرت هذا العام على خادم ArXiv، أظهر ليو وزملاؤه أن هذه الدوال البسيطة خارج الخلايا العصبية أسهل بكثير في التفسير، مما يجعل من الممكن إعادة بناء الشكل الرياضي للدالة التي تتعلمها KAN بالكامل 📐.

ومع ذلك، اختبر الفريق تفسير KANs فقط على مجموعات بيانات اصطناعية بسيطة، وليس على مشاكل العالم الحقيقي، مثل التعرف على الصور، التي هي أكثر تعقيدًا. يقول ليو: “نحن ندفع الحدود ببطء. التفسير يمكن أن يكون مهمة صعبة للغاية” 🛤️.

أظهر ليو وزملاؤه أيضًا أن KANs تزداد دقة في مهامها مع زيادة الحجم أسرع من MLPs. أثبت الفريق النتيجة نظريًا وأظهرها تجريبيًا في المهام المتعلقة بالعلوم (مثل تعلم تقريب الدوال ذات الصلة بالفيزياء). يقول ليو: “لا يزال من غير الواضح ما إذا كانت هذه الملاحظة ستمتد إلى المهام التقليدية لتعلم الآلة، ولكن على الأقل بالنسبة للمهام المتعلقة بالعلوم، يبدو الأمر واعدًا” 🌟.

ومع ذلك، يعترف ليو بأن KANs تأتي بعيب واحد مهم: أنها تتطلب وقتًا وقوة حسابية أكبر للتدريب مقارنةً بـ MLP 🚀.

يقول دي تشانغ من جامعة شيان جياوتونغ-ليفربول في سوتشو، الصين: “هذا يحد من كفاءة تطبيق KANs على مجموعات البيانات الكبيرة والمهام المعقدة”. لكنه يقترح أن الخوارزميات الأكثر كفاءة والمعجلات المادية يمكن أن تساعد في التغلب على هذا القيد 🚀.

اقرأ أيضًا: الصراع التكنولوجي بين الصين وأمريكا في مجال الذكاء الاصطناعي: تحديات هواوي أمام هيمنة إنفيديا 🤖